Topologi

Table Address

·

Admin-node -> 172.16.11.183

·

node_1 ->

172.16.11.180

·

node_2 ->

172.16.11.181

·

node_3 ->

172.16.11.182

·

client ->

172.16.11.184

Tujuan Pembelajaran

·

Agar tahu apa

itu Ceph Cluster

·

Agar tahu cara

kerja dari Ceph Cluster

·

Agar tahu

konfigurasi Ceph Cluster

Konsep Dasar

Ceph

adalah platform unified storage software gratis yang dirancang untuk menyajikan

objek, blok, dan penyimpanan file dari cluster didistribusikan tunggal yang

berfungsi sebagai storage server atau server penyimpanan seperti google drive.

Tujuan utama Ceph ini yang harus benar-benar didistribusikan tanpa titik

kegagalan, scalable ke tingkat exabyte, dan bebas-tersedia.

Admin-node berfungsi untuk menginstalasi

ceph ke node1, node2, node3, dan client. Karena, jika kita instalasi satu

persatu keyringnya akan berbeda dan ceph sendiri tidak akan saling

sinkronisasi. Untuk OSD, menggunakan node1, node2 dan node3 dengan menggunakan

harddisk tambahan ke masing-masing node. MON dan MDS hanya perlu diinstal pada

node1. Untuk kliennya sendiri harus di upgrade kernelnya, karena ceph tidak

support menggunakan kernel 2.x.

Konfiurasi

1. Edit file hosts pada

seluruh node, untuk memudahkan mengingat setiap namanya agar mudah saat

melakukan konfigurasi. Ketikkan perintah

vi /etc/hosts

2. Matikan firewall dan

selinux pada admin node, seluruh node dan client. Ketikkan perintah dibawah,

dan pada bagian SELINUX ubah menjadi disabled

vi /etc/selinux

3. Ketikkan perintah setenforce

0 dan matikan firewall nya dengan mengetikkan perintah

setenforce 0

iptables –F

chkconfig iptables off

4. Pada admin-node,

install open ssh dengan mengetikan perintah

yum install openssh-clients –y

5. Bila proses

installasi sudah selesai ketikkan perintah ssh-keygen

6. Ketikkan perintah

dibawah yang berguna untuk ketika kita melakukan ssh ke node lain, maka kita

tidak akan lagi memasukkan password

ssh-copy-id -i ~/.ssh/id_rsa.pub node_1

ssh-copy-id -i ~/.ssh/id_rsa.pub node_2

ssh-copy-id -i ~/.ssh/id_rsa.pub node_1

ssh-copy-id -i ~/.ssh/id_rsa.pub client

7. Download paket epel

dan ceph nya tapi sebelumnya install dahulu paket wget

wget -c http://ceph.com/rpm-firefly/el6/noarch/ceph-release-1-0.el6.noarch.rpm http://dl.fedoraproject.org/pub/epel/6/x86_64/epel-release-6-8.noarch.rpm

8. Setelah melakukan

install wget, sekarang download paket epel dan ceph nya dengan mengetikkan

perintah

rpm-ivh ceph-release-1.0.16.noarch.rpm

rpm-ivh epel-release-6-8.noarch.rpm

9. Tambahkan priority=1

sebelum melakukan install ceph dan ceph-deploy dengan mengetikan perintah

sed -i -e “s/enabled=1/enabled=1\npriority=1/g” /etc/yum.repos.d/ceph.repo

10.

Install yum-plugin-priorities dengan mengetikkan perintah

yum install yum-plugin-priorities –y

11.

Install ceph dan ceph-deploy nya dengan mengetikkan perintah

yum install ceph ceph-deploy

12.

Buat direktori pada direktori /etc

dengan nama ceph-cluster untuk tempat

menyimpan konfigurasi ceph

13.

Masuk pada direktori /etc/ceph-cluster dan

ketikkan perintah dibawah ini untuk membuat ceph MON ke node1

ceph-deploy new node_1

14.

Jika installasi MON sudah selesai, sekarang install ceph ke node1 – node3.

Dengan mengetikkan perintah

ceph deploy install admin node_1 node_2 node_3

15.

Setelah selesai install, buatlah admin-keyring dengan menggunakan perintah

ceph-deploy mon create-initial

16.Format

harddisk yang akan digunakan menjadi object storage pada node_1 node_2 node_3

dengan mengetikkan perintah

parted -s /dev/sdb mklabel gpt parted -s /dev/sdb mkpart primary xfs 0% 100% mkfs.xfs /dev/sdb1 –f

17.

Buat direktori /ceph-osd untuk

mounting otomatis partisi yang sudah diformat tadi, mounting partisi partisi

tersebut dengan menggunakan perintah

mount -t xfs /dev/sdb1 /ceph-osd/

18.

Edit file /etc/fstab dan tambahkan

script mounting otomatisnya, berfungsi ketika server restart maka akan otomatis

memounting partisi tersebut. Ketikkan perintah dibawah ini, dan tambahkan

script seperti tulisan kuning pada gambar dibawah

/dev/sdb1 /ceph-osd xfs defaults 0 0

19.

Buat ceph object / OSD pada admin node. Dengan mengetikkan perintah

ceph-deploy osd prepare node_1:/ceph-osd node_2:/ceph-osd node_3:/ceph-osd

20. Setelah dibuat ceph objectnya, sekarang aktifkan ceph objectnya dengan mengetikkan perintah

ceph-deploy osd activate node_1:/ceph-osd node_2:/ceph-osd node_3:/ceph-osd

21.

Copy kan file konfigurasi ceph dari admin-node ke node_1 sampai node_3

ceph-deploy admin admin-node node_1 node_2 node_3

22.

Berikan hak akses read pada file ceph.admin.keyring, ketikkan perintah

chmod +r /etc/ceph-cluster/ceph.client.admin.keyring

23.

Buat metadata server ke node_1 dengan mengetikkan perintah

ceph-deploy mds create node_1

24.

Pada node_1 node_2 node_3, jalankan perintah dibawah ini untuk mengcek status

kesehatan ceph

ceph health

25.

Cek juga quarom status dengan mengetikkan perintah

ceph quorum_status –format=json-pretty

26.

Cek status OSD dan cek status ceph pada node_1 node_2 node_3

ceph osd stat service ceph status

27. Lihat status OSD dan lihat kapasitas harddisk ceph dengan mengetikkan perintah

ceph osd treeceph df

28.

Install xen dengan mengetikkan

perintah dibawah ini, yang digunakan untuk menstabilkan ceph kita. Karena

disini saya menggunakan virtualisasi

yum install centos-release-xen

29.

Upgrade kernel centos, karena ceph tidak support dengan kernel 2.x dan ceph

lebih support dengan kernel 3.x, bila sudah diupgrade lakukan lah pengecekkan

yum update-kernel –y uname –a

30.

Kemudian pada admin-node install ceph ke client dan coba salin keyring ke

client

ceph-deploy install client

ceph-deploy admin client

31.

Pada client, buat block device dari client dengan membuat disk baru dengan

menggunakan rbd dan buat mapping disk yang sudah dibuat

rbd create disk1 –size 5012 rbd map disk1 rbd showmapped

32.

Format disk yang sudah di mapping

mkfs.ext4 /dev/rbd2

33.

Sehabis diformat, lakukan mounting partisi tersebut

34.

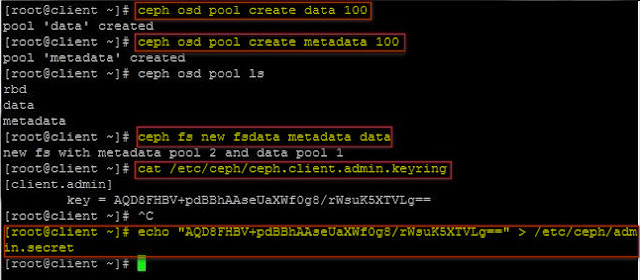

Buat pool pada ceph OSD

ceph osd pool create data 100 ceph osd pool create metadata 100

35. Buat secret file dengan menyalin key dari

file ceph client admin keyring. Kemudian salin key tersebut dan buat untuk

menyimpan key

36.

Buat direktori untuk mounting driver ceph

mkdir /mnt/cephfs mount -t ceph 192.168.100.202:6789:/ /mnt/cephfs -o name=admin,secretfile=/etc/ceph/admin.secret

37.

Install paket ceph-fuse pada client

yum install ceph-fuse –y

38. Buat direktori dan mounting dengan filesystem

mkdir mycephfs ceph-fuse -m 192.168.100.202:6789 mycephfs/

39.

Uji coba pada client, pada ceph filesystem

40.

Kemudian cek hasil mounting ceph filesystem

0 komentar:

Posting Komentar